Elia Marin e la scienza

Per molto tempo ho minacciato il buon Michelangelo Coltelli dicendogli che avrei scritto un pezzo sulla scienza per lui e per gli amici di Butac. Di recente però ho assistito a una schermaglia senza precedenti tra sostenitori e oppositori della scienza “ufficiale”, dove il termine virgolettato indica un’immaginaria divisione tra quello che viene sostenuto dalla stragrande maggioranza della comunità scientifica e quello che viene sostenuto da pochi elementi, spesso senza alcun dato di sostegno. De facto, sarebbe più corretto dire che la divisione è tra “scienza” e “non-scienza”, dato che la presenza di dati di sostegno è requisito fondamentale.

Perché si fa così fatica a credere nella scienza? È un quesito che mi pongo quotidianamente, leggendo le pagine dei giornali e i social network. Credo che la risposta stia nella natura complessa, oscura e crudele dell’universo, così difficile da comprendere e allo stesso tempo affascinante e spaventoso. In molti casi non credo vi sia un rifiuto di accettare la scienza, quanto un timoroso pregiudizio che potrebbe essere facilmente superato con un minimo di istruzione. Vedo lo stesso pregiudizio, anche se di segno opposto, tra alcuni sostenitori della scienza, gente che non avendo le basi necessarie riporta dati e spiegazioni in modo errato o travisato. Vorrei solo dire a questi ultimi che apprezzo il loro entusiasmo, ma che oggi stanno facendo più danni che altro.

Così ho finalmente deciso di scrivere queste righe, per molti versi il sunto della mia carriera nel campo della ricerca, in cui ho iniziato a lavorare ormai nel lontano 2007. Il pezzo è firmato: siete liberi di verificare la mia identità, di criticare la mia esperienza, il mio lavoro, le mie opinioni. Spero solo che quello che ho da raccontarvi possa esservi di stimolo e magari aiutarvi ad accettare la scienza, perché accettare è il primo e più importante passo da fare quando si vuole davvero capire.

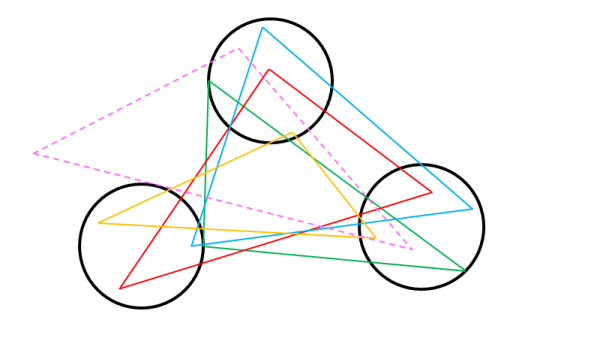

Correva l’anno 1997 ed ero al liceo, la prima di un numero infinito di lezioni di fisica con un professore giovane e appassionato della materia, di cui ancora oggi ho un meraviglioso ricordo. Ci portò un foglio di carta fotocopiato con sopra disegnato un triangolo del tutto simile a quello in figura:

Il nostro compito era molto semplice: misurare i tre lati. Ricordo che all’epoca fui uno dei primi a consegnare: avevo scritto “15 cm” “20 cm” e “25 cm”. Mi aspettavo che il professore commentasse, che dicesse che avevo risposto correttamente, d’altra parte per me era così chiaro che quel triangolo disegnato con squadra e pennarello fosse esattamente di quelle dimensioni precise. Quello che il professore però ci disse fu che tutti noi, indipendentemente dai risultati presentati, avevamo sbagliato. Quel triangolo che ci appariva così semplice e perfetto non era nemmeno un triangolo: i tre vertici non erano puntiformi ma all’incirca circolari, i tre lati non erano segmenti monodimensionali ma rettangoloidi e gli angoli… Beh, gli angoli non avrebbero mai potuto essere precisamente quelli 30, 60 e 90 gradi (NdR: Elia ricorda male! La trigonometria non è un’opinione), ci sarebbe stato sempre un certo grado di errore intrinseco nel disegno. I valori che avevo indicato erano veri forse solo in prima approssimazione, ma dipendeva comunque dallo scopo per cui il triangolo era stato disegnato.

Fui talmente turbato dalla semplice, palese razionalità della risposta che quella lezione fu per me l’insospettabile incipit di una carriera dedicata alla scienza e alla comprensione.

Comprendere la scienza

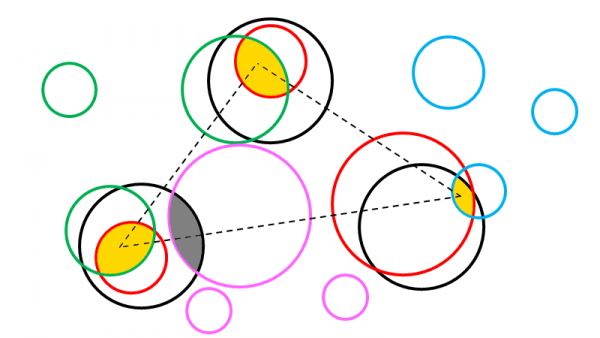

Ora cercherò di utilizzare lo stesso semplicissimo strumento per spiegare come sia possibile, e per certi versi facile, comprendere la scienza. Immaginiamo ad esempio che ogni “punto”, ovvero ogni “cerchio” che si trova ai vertici del triangolo sia l’esito di un esperimento (i nostri dati) e che il “triangolo” che tracciamo sia la nostra interpretazione. Se diamo un’occhiata ai punti possiamo però facilmente notare che per gli stessi tre cerchi passano infiniti triangoli, di cui due in figura:

Si potrebbe dire che tutti e tre i triangoli (nero, rosso e verde) sono praticamente identici, questo perché in fondo i nostri tre “punti” iniziali avevano un diametro relativamente piccolo rispetto alla lunghezza dei lati.

Ma cosa influenza la dimensione dei nostri cerchi, ovvero l’affidabilità dei nostri risultati sperimentali? La lista è purtroppo molto lunga. Per prima cosa prendiamo in considerazione la variabile meno controllabile, che è l’operatore. La sua esperienza, la sua motivazione, la cura con cui ha trattato i dati sono solo tre delle infinite variabili che regolano le sue performance e non c’è un modo facile e veloce di garantire che l’operatore lavori sempre allo stesso modo. Anche una semplice nottata in bianco può influire su esperimenti in cui l’azione umana gioca un ruolo preponderante, come nel campo della biologia o nella microscopia. Il peggiore male che può però affliggere un operatore è un bias: un preconcetto che lo porta a trattare in un modo “diverso” il campione. Metà della mia tesi di dottorato, per portare un esempio di vita vissuta, è stato costruito su campioni inizialmente scartati perché considerati troppo differenti dagli standard tecnologici del tempo. Una volta superato il bias iniziale, quei campioni sono stati una vera e propria miniera di interessanti risultati sperimentali.

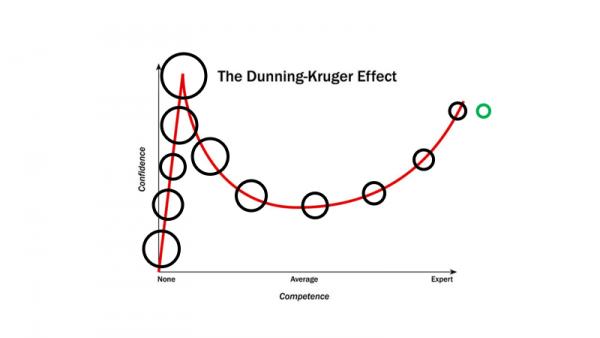

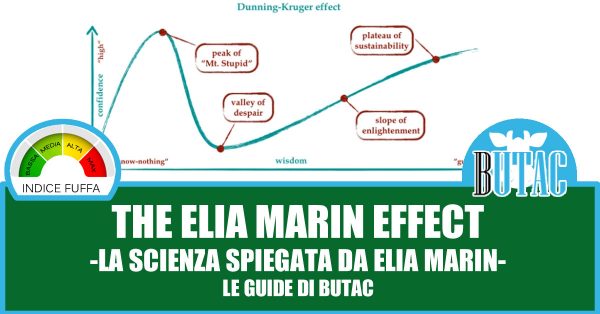

L’effetto Dunning-Kruger

Lasciatemi spendere però qualche riga su un concetto che si è lentamente fatto largo nei social, quello dell’effetto Dunning-Kruger. Molti di voi ne avranno sentito parlare e alcuni saranno probabilmente stati accusati di esserne un esempio: l’effetto è in realtà una distorsione cognitiva per cui la fiducia nelle proprie capacità cresce molto più velocemente di quanto detterebbe la reale competenza. In generale, in una fase di relativa inesperienza, tendiamo quindi a sopravvalutare le nostre reali conoscenze e capacità. In figura, potete vedere come questo affligge l’affidabilità dei nostri risultati sperimentali (i cerchi rappresentano i vertici del triangolo precedente), portando addirittura spesso a un calo (aumento di diametro) con l’esperienza, che sembrerebbe anti-intuitivo. In laboratorio capita di continuo ai ricercatori alle prime armi: iniziano a fare errori stupidi dettati da una troppo alta fiducia nelle proprie capacità. In verde ho rappresentato quella che è la dimensione ideale al netto dell’influenza dell’operatore, ottenibile forse solo per competenza infinita. Giusto per farsi un’idea.

Il secondo punto è la qualità e qualità dei campioni: quando e come sono stati prodotti, quanto sono uniformi nelle caratteristiche, quante informazioni in merito sono note. L’intera loro anamnesi è fondamentale perché ogni minimo dettaglio può avere influenze impreviste sull’esito finale. Per fare un esempio lampante, ricordo una partita di cinque ruote dentate, formalmente identiche, prodotte da un unico fornitore. Quattro ruote su cinque si sono sbriciolate come un cracker dopo poche ore di funzionamento. L’ultima ruota, in funzione tutt’ora a distanza di cinque anni, era quella su cui era stata fatta la caratterizzazione dell’intero lotto. Il campione non era evidentemente significativo, non avevamo dall’inizio le informazioni necessarie, tra cui, in particolare, le strane condizioni dei trattamenti termici.

Il terzo punto è la qualità e adeguatezza dello strumento utilizzato. Regolari manutenzioni, calibrazioni, settaggi, l’uso nel rispetto dei limiti imposti dal produttore lasciando la macchina solo nelle mani di operatori qualificati sono fondamentali requisiti per ottenere dati ripetibili e affidabili. Una vecchia macchina analogica difficilmente avrà la precisione e la risoluzione di una moderna macchina digitale, e l’usura dei componenti inesorabilmente degrada la qualità con lo scorrere del tempo. Ma bisogna anche tener conto dell’adeguatezza, come ho chiarito poco sopra. Se pretendo di fare misurazioni di composizione chimica affidabili utilizzando un (unico, magari) marcatore colorato, ad esempio, devo aspettarmi un’incertezza sperimentale gigantesca se comparata a tecniche moderne e affidabili come le analisi ICP, precise fino alle parti per miliardo. Questo significa che anche dati sperimentali simili, se ottenuti con tecniche differenti, possono avere diversi gradi di affidabilità. Per questo in genere si cerca di lavorare con le cosiddette tecniche di conferma, ovvero accoppiando tra loro analisi che possono fornire in modi diversi lo stesso risultato, anche se singolarmente magari meno affidabili. Questo tipo di esperimenti aumenta di molto l’affidabilità finale del dato.

Quando gli esperimenti sono affidabili, il diametro dei punti è trascurabile rispetto alla distanza tra i punti e la forma che otteniamo è (quasi) univoca. Significa che tutte le interpretazioni che possiamo dare ai nostri dati sono simili e non ci sono grossi rischi di commettere errori in questa fase. Mano a mano che ci allontaniamo dalla matematica ed entriamo nel campo delle materie biologiche, meno i singoli esperimenti sono capaci di darci dati rappresentativi e affidabili, tanto che se dovessi fare uno schema per la medicina, apparirebbe probabilmente come in figura:

Potete facilmente notare quante interpretazioni sostanzialmente differenti possa dare dei miei dati sperimentali senza uscire dal raggio del cerchio, sebbene una sola (o comunque un gruppo limitato) sia quella corretta. Vi è inoltre un punto importante su cui mi è capitato spesso di discutere: il fatto che l’affidabilità dei risultati sia bassa non mi autorizza a ignorare il dato acquisito e trarre conclusioni al di fuori delle possibilità. Il triangolo tratteggiato è evidentemente errato perché passa per solo due dei miei tre risultati sperimentali, ignorando completamente il terzo.

Detto questo, come posso affermare che un’interpretazione sia corretta se i miei dati sono singolarmente così poco affidabili?

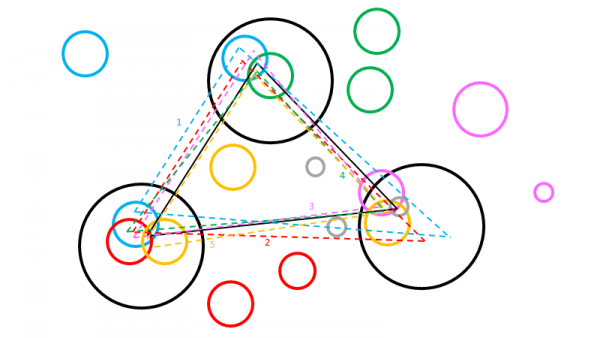

Ci sono diverse strade. La prima è ripetere gli esperimenti più e più volte, cercando di togliere qualsiasi influenza esterna sull’affidabilità dei risultati. Successivamente ci si può rivolgere alla letteratura e comparare i propri dati con quelli degli altri ricercatori. Ma non ci si deve aspettare una risposta chiara e immediata, il risultato assomiglierà più a quello in figura, in cui ogni set di colore diverso rappresenta i risultati ottenuti in letteratura da esperimenti simili.

Ovviamente, per la maggior parte degli argomenti le fonti che troverò saranno ben maggiori delle quattro che vengono mostrate qui. Alcuni risultati, come ad esempio i cerchi rossi, potrebbero essere ottenuti utilizzando le stesse tecniche ed in condizioni molto simili se non formalmente identiche. Ciò non toglie che l’affidabilità dei dati possa essere diversa. Altri risultati, come i cerchi verdi, potrebbero essere ottenuti su un argomento simile, con tecniche simili ma non completamente confrontabili. Per i cerchi rosa e azzurri si tratta invece di esperimenti differenti che solo parzialmente si sovrappongono al mio lavoro. Combinando insieme i miei dati, quelli verdi, quelli rossi e quelli azzurri ottengo una famiglia di interpretazioni dei risultati che sono molto simili tra loro, ben più coerenti di quelle dell’immagine precedente. In questo caso però, per poter fornire la mia interpretazione, ho dovuto scartare il set di risultati sperimentali rosa, dato che non erano coerenti con quello rosso e quello verde. Perché ho scelto il rosa e non verde e rosso?

Perché una fonte è migliore/peggiore di un’altra?

La faccenda qui è un po’ complessa e si lega strettamente a molte delle polemiche che si leggono ogni giorno online. Come faccio a decidere quale debba essere presa in considerazione?

Nel nostro caso potrei aver usato due approcci. Il primo meramente numerico: ci sono più lavori che supportano questa interpretazione (nera verde e rossa) rispetto alla interpretazione rosa e nera. Il secondo potrebbe essere legato alla qualità: il cerchio rosa in basso a sinistra è decisamente più grande di quello verde e di quello rosso, potrei pensare che il risultato ottenuto non sia sufficientemente affidabile.

Nella realtà chi fa questo mestiere utilizza spesso un approccio misto. Si cerca di avere una base di letteratura di riferimento solida, sia per quantità che per qualità. Ma anche scegliessi di usare una fonte non del tutto affidabile perché più coerente ai miei risultati, magari perché unica nel suo genere, mi sarebbe comunque sufficiente citarla per consentire al lettore di valutare successivamente il mio lavoro. Anche se l’articolo si rivelasse successivamente una frode, il lettore sarebbe comunque al sicuro perché in grado di risalire autonomamente alla fonte di quel riferimento e verificare la sua affidabilità. Citare correttamente la bibliografia non è semplicemente un dare maggior peso alle proprie posizioni, è soprattutto un dire: “Attenzione, non me lo sono inventato, è scritto così in quest’altro lavoro”.

Alla fine quello che succede in campi complessi come quello della medicina è una continua evoluzione e affinazione delle interpretazioni, confrontando molti lavori e molte tecniche e scartando via via le vecchie interpretazioni rivelatesi errate. Si passa così dall’interpretazione nera e azzurra a quella nera azzurra e rossa, a quella nera-azzurra-rossa-rosa, a quella nera-azzurra-rossa-rosa-verde, a quella nera-azzurra-rossa-rosa-verde-gialla, a quella finale nera-azzurra-rossa-rosa-verde-gialla-grigia. Questo richiede tempo e molti gruppi di ricerca che lavorino sullo stesso argomento generale, che è il motivo per cui esistono fondazioni il cui scopo è finanziare la ricerca per una specifica patologia. Se consideriamo la medicina, gli esperimenti che hanno solo un punto in comune con l’interpretazione finale potrebbero essere ad esempio simulazioni numeriche (grigio), ma anche modelli animali ed esperimenti in vitro.

La malafede dei ricercatori

Passiamo però ora ad un’altra questione importante. Ho letto molto spesso pareri di gente convinta che scienziati e ricercatori siano in malafede, mossi da interessi personali o comunque disonesti. Sugli interessi personali non posso discutere, è una questione che deve essere giudicata con estrema severità, caso per caso, andando a vedere finanziamenti e vantaggi ottenuti. Bisogna però tenere in considerazione che la stragrande maggioranza della ricerca pubblica e privata è svolta da professionisti al minimo salariale che non hanno contatti diretti con i finanziatori delle loro ricerche (se presenti) e che vedrebbero la propria carriera distrutta se finissero al centro di uno scandalo. Questo dovrebbe ragionevolmente farci supporre che possa al più essere una minima frazione della ricerca ad essere influenzata.

Per la parte dell’onestà, parola con cui la gente ama davvero riempirsi la bocca, ritengo che siamo tutti disonesti. Dal primo all’ultimo. Non esiste un singolo ricercatore o scienziato completamente onesto su questa terra. Di più: ritengo che non ci sia nessun essere umano completamente onesto. Questo perché siamo continuamente affetti da ogni tipo di influenza e bias cognitivo che ci porta a commettere inconsapevolmente degli errori. Il vantaggio di scienziati e ricercatori, rispetto a molte altre categorie lavorative, è che devono sottostare ad una serie di regole precise che li rendono generalmente più credibili e affidabili. Non tutti, ovviamente. Ci sono scienziati anche “famosi” (forse “noti” è un termine più adeguato in questo caso) che si fregiano di titoli inesistenti, che pubblicano su riviste non credibili, che vantano laboratori e attrezzature ben superiori alla realtà dei fatti, che pubblicano libri senza revisioni piuttosto che confrontarsi con i loro pari. Insomma, tutti gli scienziati (gli umani) sono disonesti, ma alcuni (pochi) sono molto più disonesti degli altri.

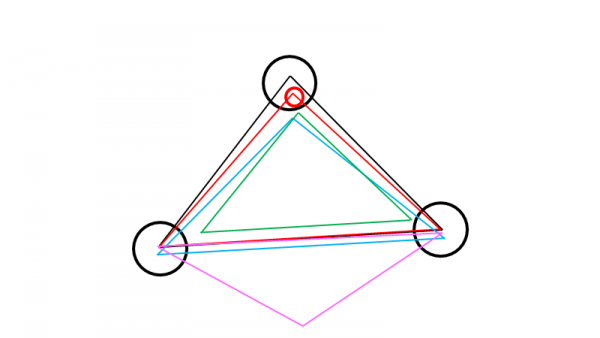

Proviamo ora a spiegare almeno le più semplici forme di errore (disonestà) in cui uno scienziato può incappare. Immaginiamo che i cerchi neri siano i reali dati in mio possesso e il triangolo nero sia non semplicemente la mia interpretazione, ma l’interpretazione di fatto corretta.

Gli errori più comuni

Un errore che ho davvero visto commettere a chiunque è quello di sovrastimare l’affidabilità dei propri risultati sperimentali (rosso), credendo così di aver ottenuto risultati molto più vicini alla realtà di quanto realmente sia. Può sembrare un errore poco grave, ma ha grande influenza soprattutto su chi in futuro vorrà fare uso di quei dati, magari per confrontarli con il proprio lavoro. Se ad esempio ottenessi come valore dell’accelerazione di gravità 9.825 m/s2 perché ho brutalmente approssimato in qualche punto e sostenessi che il valore è esatto fino alla terza cifra decimale, lo studioso successivo che ottiene 9.81 m/s2 potrebbe pensare di essere in errore anche se il suo dato è in realtà più preciso del mio. I due cerchi potrebbero sembrare disgiunti anche se nella realtà dovrebbero essere intersecanti.

Un altro errore tristemente comune è quello di trarre interpretazioni errate da un dato, andando quindi al di fuori del suo significato reale (azzurro). Potrei ad esempio pensare che dato che l’argento ha un colore simile all’alluminio, la sua riflettenza alle basse lunghezze d’onda sia simile. La risposta breve per la cronaca è: “No, solo alle alte e dipende da cosa intendi per simile”.

Un altro possibile errore (rosa), comune principalmente nei lavori degli studenti con poca esperienza e nelle riflessioni dei complottisti, è credere che un dato (mancante) sia vero semplicemente perché gli altri dati sono confermati dalla letteratura. Sia l’acqua che l’acqua ossigenata sono incolori e inodori, ma sebbene l’acqua sia anche potabile, l’acqua ossigenata non lo è.

Il caso di gran lunga peggiore è però quello di sostenere senza dati che la propria ipotesi sia vera sulla base di un’interpretazione simile ma ottenuta su dati reali (verde). Non capita praticamente mai nella reale letteratura scientifica, ma è il cuore delle teorie del complotto, in particolare quando si parla di eventi difficilmente replicabili paragonandoli a eventi apparentemente simili. Un po’ come quello che succede con le teorie dell’11 settembre riguardanti gli esplosivi, il collasso degli edifici e i danni strutturali. Ci si rifà a modelli simili, senza rendersi conto di quanto possano essere distanti dalla realtà.

Concludendo

Ci sarebbero molte altre cose da dire, tanti altri punti da trattare, ma credo che aggiungere altro adesso possa solo generare più confusione. L’importante è capire o almeno intuire i meccanismi che si nascondono dietro la scienza e il modo di fare scienza, l’intepretazione dai dati, la statistica, l’affidabilità. Poi ciascuno è libero di usare la propria testa, a patto che sia consapevole dell’esistenza di meccanismi consolidati e sicuri, di meccaniche precise e di esperienze difficilmente ottenibili per semplice intuizione.

Elia Marin